Nous sommes bientôt à un mois de la clôture de Big Data AI Paris 2023 ; cet événement intervient juste après Big Data London. Tous deux présentent des affluences fortes ! A Paris, c’est quelques 16.500 participants qui ont été dénombrés. C’est de mieux en mieux. Il y a des personnes qui suivent à distance ; le niveau de participation de 2019 est bientôt atteint.

Ces chiffres pour rappeler l’importance que revêt le sujet de la donnée.

Oui, LLM ne vous est plus inconnu ! Oui, il était sur toutes les lèvres cette année. Et “Data Product” aussi ! L’enthousiasme autour de la donnée était bien présent. L’équipe de Synaltic sur le stand de Dremio, a beaucoup été interrogée quant à

rendre la donnée plus accessible et actionnable

.

Hadoop n’est pas mort ! Deux distributions open source portées par des organisations françaises étaient présentes.

Ce qui contrastait avec l’omniprésence du Cloud.

Et cette question et après le cloud ? Et bien une réponse dans Les Echos !

Connaissez-vous « l’effet de levier » ?

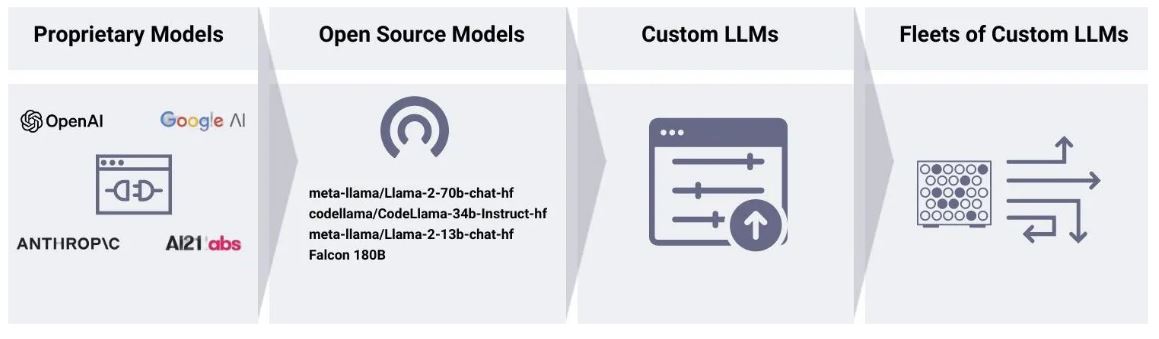

Voilà bientôt un an que le buzz médiatique a propulsé LLM. Maintenant que nous dépassons l’emballement médiatique, que certains proposent un chemin pour les adopter, leurs emplois et l’impact sur les activités métier sont bien mieux visibles.

Dans la données, poser votre question, la requête SQL qui y répond est générée automatiquement . Une nouvelle étape dans l’adoption des données est ainsi en route.

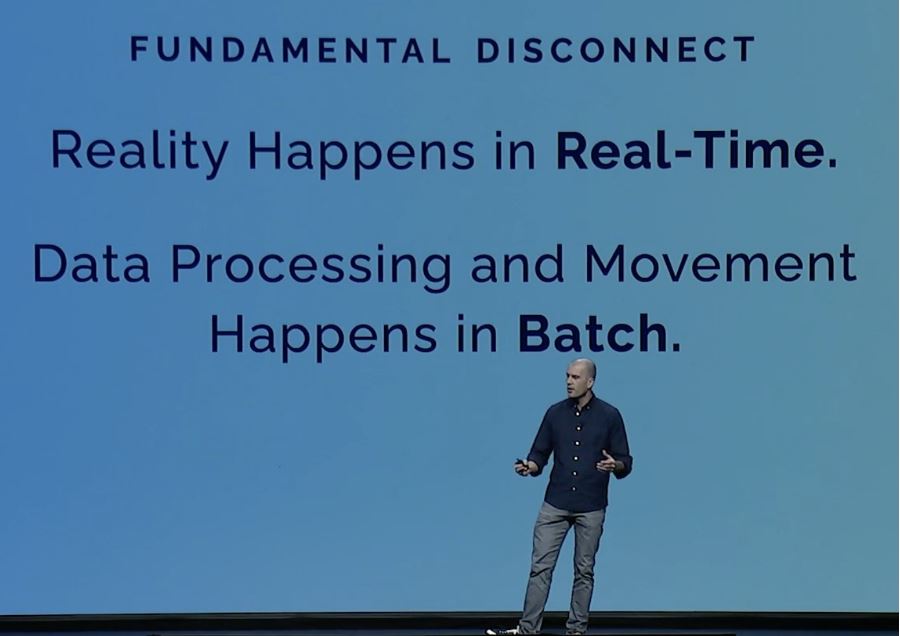

VJay Kreps, le CEO de Confluent durant Current 23 , la conférence dédiée aux technologies de streaming, lançait la conférence avec “La réalité se produit en temps réel”.

L’activité des entreprises aussi est en temps réel ! Cependant les contraintes technologiques ont conduit à adopter les traitements par lots. Il est plus que temps de briser ce paradigme.

Justement, il affichait leur offre Apache Flink en SAAS pour encore mieux profiter de la programmation événementielle . Cette disponibilité d’Apache Flink dans le cloud de Confluent en fait désormais le cadre de développement de facto pour le streaming. Un cadre de développement ouvert , certainement le plus ouvert en comparaison à KSQLdb, Spark Structured Streaming, ou les autres approches propriétaires.

Current 23

a aussi été le moment des startups ! En effet, il y a comme un renouvellement de l’offre en marche. Une chose est certaine, toutes les solutions nées il y a maintenant une quinzaine d’années sont installées. Challengers quand elles ont démarré, il est maintenant l’heure qu’elles soient à leur tour

bousculées par des offres qui adoptent leur protocoles matures

, leur offre qui n’est plus des niches.

Ces startups ont aussi l’avantage de proposer des solutions basées sur des technologies “actuelles” qui tirent mieux parti des ressources matérielles modernes. Elles sont plus efficientes. Ce qui est économiquement meilleur. Et meilleur pour la planète : la frugalité fait aussi partie de l’équation.

David Pilato est évangéliste pour Elasticsearch depuis plus de 10 ans et en charge de groupe utilisateur français. Il organise depuis quelques mois, chaque jour, un LIVE à midi . Les évènements durent moins de 15 minutes, ils sont accessibles via LinkedIn et sont gratuits.

Pour suivre l’actualité d’Elasticsearch (en anglais), inscrivez-vous aux prochaines sessions ou visionnez les enregistrements des évènements passés qui sont disponibles en replay !

Logiciels

Valhalla est un projet open source dans la sphère du géomatique. Il se compose d’un moteur de routage et les librairies associées et se base sur les données OpenStreetMap.

Valhalla comprend également des outils tels que le calcul matriciel temps + distance, les isochrones, l’échantillonnage d’altitude, la correspondance de cartes et l’optimisation des visites (Travelling Salesman).

Ce moteur de calcul d’itinéraire est utilisé par une communauté large qui va de Tesla, BMW, Mapillary, Mapbox.

Elementary est une solution open source d’observabilité des données destinée aux ingénieurs en données et analystes. Il s’agit de surveiller votre projet dbt et vos données.

L’idée est d’être informé des problèmes de données au plus tôt : bénéficiez d’une visibilité immédiate, détectez les problèmes, envoyez des alertes exploitables et comprenez l’impact et la cause première dans vos chaînes de données dbt.